BertModel是一个基本的BERT Transformer模型,包含一个summed token、位置和序列嵌入层,然后是一系列相同的self-attention blocks(BERT-base是12个blocks,

2018-11-13 09:12

如果双向如此强大,为什么以前没有这样实现?在训练单向模型时,预测词时必须只能基于句子中上文的单词。然而,想要直接让模型同时根据上文和下文来预测词是不可能的,因为这将允许被预测的单词会随着多层模型间接地 “看见自己”。

2018-11-08 15:46

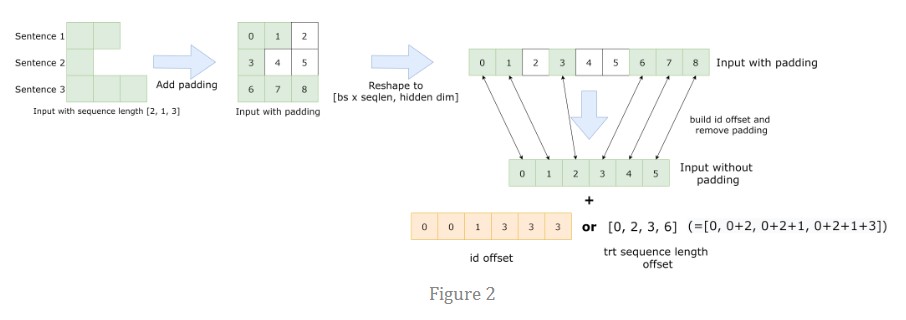

FasterTransformer BERT 包含优化的 BERT 模型、高效的 FasterTransformer 和 INT8 量化推理。

2023-01-30 09:34

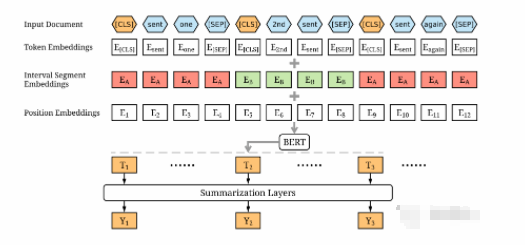

最近在梳理文本摘要相关内容,翻到一篇19年关于基于BERT模型进行抽取式摘要的老文「BertSum」,在这里分享给大家。该论文一开始挂在arXiv时,为《Fine-tune BERT

2022-03-12 16:41

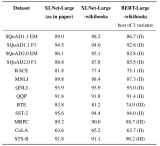

本文首先讲讲我对XLNet和Bert比,有什么异同?有什么模型方面的改进?的理解

2019-07-26 14:39

训练语料库:Wikipedia + BooksCorpus,在处理Wikipedia时使用了与BERT repo相同的工具,但出于某种原因,我们的Wiki语料库仅有20亿单词,BERT使用了25亿单词,因此XLNet的训练数据略少于

2019-07-27 07:14

随着信号的速率越来越高,调制格式越来越复杂,对测试仪器的性能要求也越来越高。是德科技也一直在推出业界领先的高带宽、高采样率的AWG和高性能的BERT。

2024-08-06 17:27

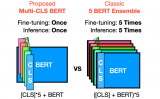

在 GLUE 和 SuperGLUE 数据集上进行了实验,证明了 Multi-CLS BERT 在提高整体准确性和置信度估计方面的可靠性。它甚至能够在训练样本有限的情况下超越更大的 BERT 模型。最后还提供了 Multi-CLS

2023-07-04 15:47

GPT和Bert则采取了另外一种应用模式:Fine-tuning。意思是:在获得了预训练模型以及对应的网络结构(Transformer)后,第二个阶段仍然采用与预训练过程相同的网络结构,拿出手头任务

2019-05-14 09:25

16.7。自然语言推理:微调 BERT¶ Colab [火炬]在 Colab 中打开笔记本 Colab [mxnet] Open the notebook in Colab Colab

2023-06-05 15:44