电子发烧友网站提供《PyTorch教程15.10之预训练BERT.pdf》资料免费下载

2023-06-05 10:53

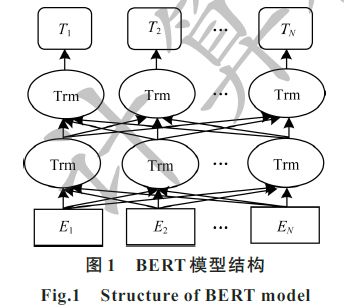

深度学习模型应用于自然语言处理任务时依赖大型、高质量的人工标注数据集。为降低深度学习模型对大型数据集的依赖,提出一种基于BERT的中文科技自然语言处理预训练模型 ALICE。通过对遮罩语言模型进行

2021-05-07 10:08

电子发烧友网站提供《PyTorch教程15.9之预训练BERT的数据集.pdf》资料免费下载

2023-06-05 11:06

电子发烧友网站提供《PyTorch教程16.7之自然语言推理:微调BERT.pdf》资料免费下载

2023-06-05 10:52

病历文本的提取与自动分类的方法具有很大的临床价值。文中尝试提出一种基于BERT十 BI-LSTM+ Attention融合的病历短文本分类模型。使用BERT预处理获取短文本向量作为模型输入,对比BERT与 word2

2021-04-26 14:30

Agilent Technologies N4900 SeriesAgilent offers a wide range of serial bit error ratio test (BERT

2010-08-11 08:56

结合文档本身的结构信息与外部词语的语义信息,提出一种融合BERT词向量与 Textrank的关键词抽取方法。在基于网络图的 Textrank方法基础上,引入语义差异性并利用BERT词向量加权方式优化

2021-03-21 09:55

针对现有中文短文夲分类算法通常存在特征稀疏、用词不规范和数据海量等问题,提出一种基于Transformer的双向编码器表示(BERT)的中文短文本分类算法,使用BERT预训练语言模型对短文本进行句子

2021-03-11 16:10

电子发烧友网站提供《PyTorch教程16.6之针对序列级和令牌级应用程序微调BERT.pdf》资料免费下载

2023-06-05 10:51

此参考设计是一款 12Gbps 低成本误码测试仪 (BERT),可生成并检查多达 8 个通道的伪随机二元序列 (PRBS)。这一经过验证的设计提供了生成高达 12Gbps 的多通道高速串行位流的便捷

2013-09-10 10:20