由于绝大多数 BERT 参数专门用于创建高质量情境化词嵌入,因此该框架非常适用于迁移学习。通过使用语言建模等自我监督任务(不需要人工标注的任务)训练 BERT,可以利用 WikiText 和 BookCorpus 等大型无标记数据集

2022-04-26 14:24

BERT原理详解

2019-07-02 16:45

A guide on using the Serial BERT

2019-09-23 11:01

BertModel是一个基本的BERT Transformer模型,包含一个summed token、位置和序列嵌入层,然后是一系列相同的self-attention blocks(BERT-base是12个blocks,

2018-11-13 09:12

A guide on programming the Serial BERT

2019-09-24 17:15

Brochure for the Keysight J-BERT N4903A High-Performance Serial BERT: 4 pages

2019-09-26 12:17

如果双向如此强大,为什么以前没有这样实现?在训练单向模型时,预测词时必须只能基于句子中上文的单词。然而,想要直接让模型同时根据上文和下文来预测词是不可能的,因为这将允许被预测的单词会随着多层模型间接地 “看见自己”。

2018-11-08 15:46

BERT的发布是这个领域发展的最新的里程碑之一,这个事件标志着NLP 新时代的开始。BERT模型打破了基于语言处理的任务的几个记录。在 BERT 的论文发布后不久,这个团队还公开了模型的代码,并提供了模型的下载版本

2020-11-24 10:08

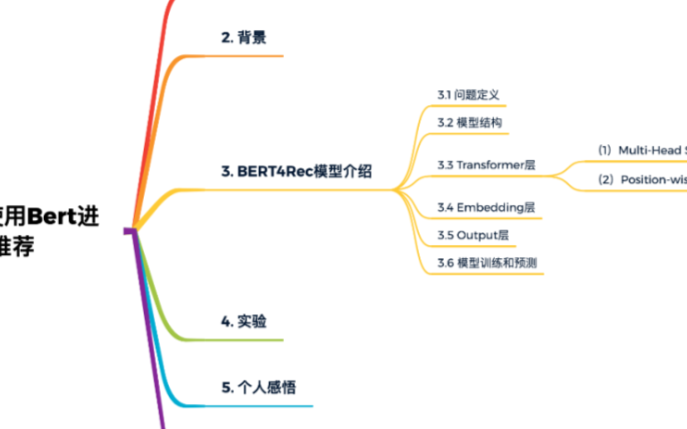

今天给大家介绍一篇BERT用于推荐系统的文章,题目是《BERT4Rec: Sequential Recommendation with Bidirectional Encoder

2020-11-03 17:11

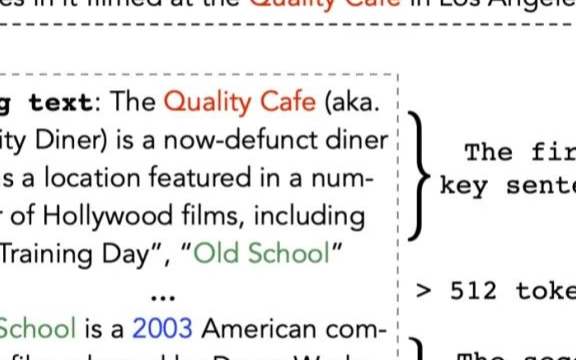

这是今年清华大学及阿里巴巴发表在NIPS 2020上的一篇论文《CogLTX: Applying BERT to Long Texts》,介绍了如何优雅地使用bert处理长文本。作者同时开源了

2020-12-26 09:17