本文提出了一种将视觉语言模型(VLM)转换为端到端导航策略的具体框架。不依赖于感知、规划和控制之间的分离,而是使用VLM在一步中直接选择动作。惊讶的是,我们发现VLM可以作为一种无需任何微调或导航数据的端到端策略来使

2024-11-22 09:42

视觉语言模型(VLM)是一种多模态、生成式 AI 模型,能够理解和处理视频、图像和文本。

2025-02-12 11:13

对此,ByteDance Research 基于开源的多模态语言视觉大模型 OpenFlamingo 开发了开源、易用的 RoboFlamingo 机器人操作模型,只用单机就可以训练。使用简单、少量的微调就可以把 VLM 变成 Robotics VLM,从而适用于

2024-01-23 16:02

视觉语言模型(VLM)通过将文本和图像投射到同一个嵌入空间,将基础大语言模型(LLM)强大的语言理解能力与视觉 transformer(ViT)的视觉能力相结合。VLM 可以处理非结构化的多模态数据

2024-11-19 15:37

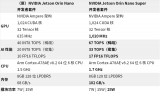

生成式 AI 领域正在迅速发展,每天都有新的大语言模型(LLM)、视觉语言模型(VLM)和视觉语言动作模型(VLA)出现。为了在这一充满变革的时代保持领先,开发者需要一个足够强大的平台将云端的最新模型无缝部署到边缘,从而获得基于 CUDA 的优化推理性能和开放式机器学习(ML)框架。

2024-12-23 12:54