大家好,我正在尝试使用VHDL实现双曲线tan tan函数,但问题是我不知道tanh函数怎么可以实现digital所以请如果任何身体可以告诉我这个想法,以便我可以在VHDL中实现它会很好的。非常感谢

2019-02-14 10:20

本帖最后由 awfeequdng 于 2012-1-11 16:14 编辑 不好意思,上一贴好像发帖的标题不规范,重新发过一下:该计算器能实现 tan,cot,cos,sin,tanh

2012-01-10 14:34

为了训练神经网络内的神经元,利用Tanh或S形非线性已成为标准做法,这是goto激活函数,可用来对CNN内的内部神经元激活进行建模。

2020-07-14 09:17

;nbsp; Tanh 双曲正切 Atan 反正切 Atan2 四象限反正切 Atanh 反双曲正切 Sec 正割 Sech 双曲正割 Asech 反双曲正割 Csc 余割 Csch

2009-09-22 16:04

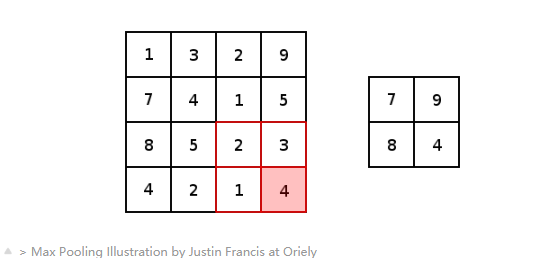

如上图所示,sigmoid的作用确实是有目共睹的,它能把任何输入的阈值都限定在0到1之间,非常适合概率预测和分类预测。但这几年sigmoid与tanh却一直火不起来,凡是提及激活函数,大家第一个想到的就是ReLU,为什么?

2018-06-30 08:55

在定义好网络结构并初始化参数完成之后,就要开始执行神经网络的训练过程了。而训练的第一步则是执行前向传播计算。假设隐层的激活函数为 tanh 函数, 输出层的激活函数为 sigmoid 函数。则前向传播计算表示为:

2018-07-26 17:22

ReLU(Rectified Linear Unit,修正线性单元)训练速度比tanh快6倍。当输入值小于零时,输出值为零。当输入值大于等于零时,输出值等于输入值。当输入值为正数时,导数为1,因此不会出现sigmoid函数反向传播时的挤压效应。

2018-05-16 11:18

该计算器能实现 tan,cot,cos,sin,tanh,cosh,sinh,x^y,开方,arcos,arcsin,arctan,log,ln,10^x,exp(x)这一系列的函数表达式的计算

2012-01-10 13:59

, Relu/PRelu/LeakyRelu/Tanh/Sigmoid 激 活,Concat/Reshape/BatchNomalizationn 等常见神经网络算子。:) 有要一起玩的小伙伴吗?论坛留言,或者可以加我微信sz-qvc

2020-12-07 17:05

、tanh、ReLU(Rectified Linear Unit 线性修正单元)和以及这些函数的变体。 二、Adadelta Adadelta 是基于梯度下降的学习算法,可以随时间调整每个参数的学习率

2017-12-08 10:36