Bert的MLM是静态mask,而在后续的其他预训练模型中,这一策略通常被替换成了动态mask。除此之外还有 whole word mask 的模型,这些都不在今天的讨论范围内。

2022-08-13 10:54

为了解决这一问题,本文主要从预训练语言模型看MLM预测任务、引入prompt_template的MLM预测任务、引入verblize类别映射的Prompt-MLM预测、基于zero-shot

2022-11-14 14:56

BERT 提出一种新的预训练目标:遮蔽语言模型(masked language model,MLM),来克服上文提到的单向性局限。MLM 的灵感来自 Cloze 任务(Taylor, 1953)。MLM 随机遮蔽模型

2019-04-19 11:35

BERT 提出一种新的预训练目标:遮蔽语言模型(masked language model,MLM),来克服上文提到的单向性局限。MLM 的灵感来自 Cloze 任务(Taylor, 1953)。MLM 随机遮蔽模型

2018-10-18 10:55

使用MATLAB2013a。license.lic文件中写入的内容:INCREMENT Aerospace_Blockset MLM 99 permanent uncounted

2018-10-09 15:22

本方案主要针对智能设备对无线(WiFi)通讯应用的基本需求,以英创的EM9283工控主板为核心,构造的一款整机原型应用方案(以下简称MLM9283)。

2019-10-12 11:50

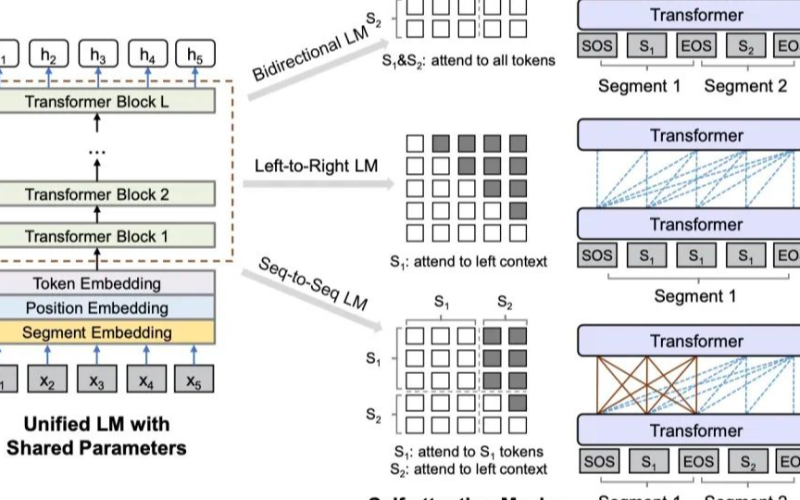

Language Model)统一到一个框架中,并且基于它们的优势和缺点,取长补短,提出了一个新的预训练语言模型----MPNet,其混合了MLM和PLM各自的优势,达到了比两者更好的效果,在Natural

2020-11-02 15:09

事实证明,印度是比特币活动的一个主要地区。不幸的是,并非这个国家的所有企业都是完全合法的。本周早些时候,一个臭名昭著的加密货币骗局的两名领导人Amit和Vivek Bhardwaj被捕。Amit和Vivek Bhardwaj是活跃在印度比特币MLM机制的负责人。

2018-12-19 13:32

天生不适合处理生成任务。 原因在于Bert的预训练过程是使用的MLM,和生成任务的目标并不一致。 生成任务目标是每次蹦出来一个词,只能看到当前位置之前的词汇。 而Bert采用的是双向的语言模型,除了mask的单词,两个方向的词汇都可以被看到。 所以对Bert的一个改进思路就是让它在具有

2021-01-03 09:25

)ML8804MLMMOTOROLA(美国摩托罗拉半导体公司)MLM301AGMMNATIONAL SEMICONDUCTOR (美国国家半导体公司)MM5430MNPANASONIC(日本松下电器公司

2006-04-17 21:06