在谈GPT 2.0之前,先回顾下它哥GPT 1.0,这个之前我在介绍Bert模型的时候介绍过,过程参考上图,简述如下:GPT 1.0采取预训练+FineTuning两个阶段,它采取

2019-02-18 09:56

GPT是一种基于Transformer的预训练语言模型,可以用于自然语言处理中的各种任务。在态势感知中,GPT可以用来对文本进行分类和情感分析,从而帮助用户了解当前的舆情和社会热点。例如,在某个

2023-07-07 11:23

GPT,全称Generative Pretrained Transformer,是OpenAI公司在自然语言处理(NLP)领域的一项重大创新。这一模型不仅推动了AI技术的边界,还深刻影响了我们与机器交互的方式。本文将从GPT的定义、来源、演进历程以及其在各个领域的

2024-07-10 10:41

虽然GPT-3没有开源,却已经有人在复刻GPT系列的模型了。 例如,慕尼黑工业大学的Connor Leahy,此前用200个小时、6000RMB,复现了GPT-2。 又例如,基于150亿参数

2021-02-13 09:24

该研究提出了一个简单而有效的框架 Control-GPT,它利用 LLM 的强大功能根据文本 prompt 生成草图。Control-GPT 的工作原理是首先使用 GPT-4 生成 TikZ 代码形式的草图。如下图

2023-06-05 15:31

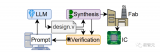

GPT-4已经会自己设计芯片了!芯片设计行业的一个老大难问题HDL,已经被GPT-4顺利解决。并且,它设计的130nm芯片,已经成功流片。 GPT-4,已经可以帮人类造芯片了! 只用简单的英语

2023-06-20 11:51

在 GPT-4 的发布报道上,GPT-4 的多模态能力让人印象深刻,它可以理解图片内容给出图片描述,甚至能在图片内容的基础上理解其中的隐喻或推断下一时刻的发展。

2023-05-22 15:21

最近有位用户想在 MATLAB 里用 m 代码实现一个将某个图形窗口最大化显示的功能,问我们有没有 MATLAB 函数支持这个。

2024-01-25 10:10

时。与此同时,作为一名坚定 C++ 的支持者,我们相信用 C++ 编写的 GPT 工具能减轻处理(无休止的)编辑批注这一艰巨任务所带来的痛苦。

2023-08-19 14:20

本文基于DeepSpeedExamples仓库中给出的Megatron相关例子探索一下训练GPT2模型的流程。主要包含3个部分,第一个部分是基于原始的Megatron如何训练GPT2模型,第二个部分

2023-06-19 14:45