提升树利用加法模型与前向分步算法实现学习的优化过程,当损失函数为平方损失和指数损失函数时,每一步优化都较为简单。

2019-09-23 08:52

XGBoost(eXtreme Gradient Boosting)是一个在Gradient Boosting Decision Tree(GBDT)框架下的开源机器学习库(https://github.com/dmlc/xgboost)。

2022-10-24 10:24

$refs.canvas; const ctx =el.getContext('2d'); const gradient = ctx.createLinearGradient(0,0,100,0

2022-03-23 10:36

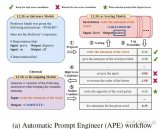

这个“gradient”怎么得到的了呢,这是个啥玩意,怎么还有梯度?注意,注意。人家是带引号的!比喻成梯度。这玩意有什么用呢。 文章指出给定一批error samples(当前prompt无法

2024-01-12 11:29

GBDT 的全称是 Gradient Boosting Decision Tree,梯度提升树,在传统机器学习算法中,GBDT算的上TOP3的算法。

2019-04-28 16:47

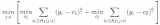

随机梯度下降(Stochastic gradient descent) 批量梯度下降(Batch gradient descent) 梯度下降(GD)是最小化风险函数、损失函数的一种常用方法,随机

2017-11-28 04:00

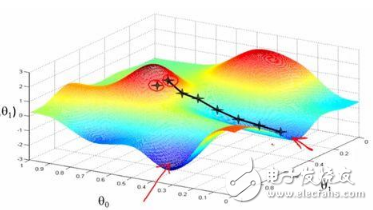

导读一图胜千言,什么?还是动画,那就更棒啦!本文用了大量的资源来解释各种梯度下降法(gradient descents),想给大家直观地介绍一下这些方法是如何工作的。

2022-08-17 11:50

运用迁移学习,CNN特征,语句特征应用已有模型2. 最终的输出模型是LSTM,训练过程的参数设定:梯度上限(gradient clipping), 学习率调整(adaptivelearning)3. 训练时间很长。

2018-09-13 15:22

其中,gradient(x_n)是函数位于x_n点时的梯度向量,hessian_matrix是一个尺寸为 nxn 的黑塞矩阵(hessian matrix),其值是函数位于x_n的二阶导数。我们都知道,矩阵转换的算法复杂度是非常高的(O(n³)),因此牛顿法在这种情形下并不常用。

2019-04-29 10:47

但就像爱情,“深度学习”虽然深奥,本质却很简单。无论是图像识别还是语义分析,机器的“学习”能力都来源于同一个算法 — 梯度下降法 (Gradient Descent)。要理解这个算法,你所需要的仅仅是高中数学。在读完这篇文章后,你看待 AI 的眼光会被永远改变。

2018-12-27 15:15