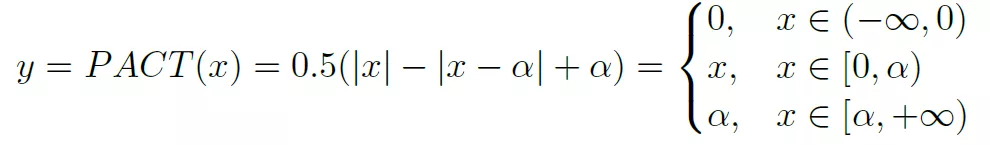

这是一种实现对activation量化的方法,基本思想是通过训练来获得ReLU的一个clip参数a。

2020-11-03 15:21

可以看到 CUDNN_BATCHNORM_PER_ACTIVATION 被用于非卷积层,在OneFlow中只有当输入Tensor的维度为2时才选取这种模式。而

2022-12-23 15:08

Hardware VAD(Voice Activation Detection) RGB/MCU display interface 2x8ch I2S/TDM, 1x8ch PDM, 1x2ch I2S

2019-10-23 10:37

计基于GPU的加速库 。cuDNN为深度神经网络中的标准流程提供了高度优化的实现方式,例如convolution、pooling、normalization以及activation layers的前向以及后向过程。 cuDNN只是NVIDIA深度神经网络软件开发包中的其中一种加速库。

2017-12-08 10:40

= 64 output_size = 784 x = Input(shape=(input_size,)) # Encoder h = Dense(hidden_size, activation=

2023-01-11 17:29

一、激活函数(Activation Function) 为了让神经网络能够学习复杂的决策边界(decision boundary),我们在其一些层应用一个非线性激活函数。常用的函数有sigmoid

2017-12-08 10:36