本文是对NCNN社区int8模块的重构开发,再也不用担心溢出问题了,速度也还行。作者:圈圈虫首发知乎传送门ncnnBUG1989/caffe-int8-conver...

2022-02-07 12:38

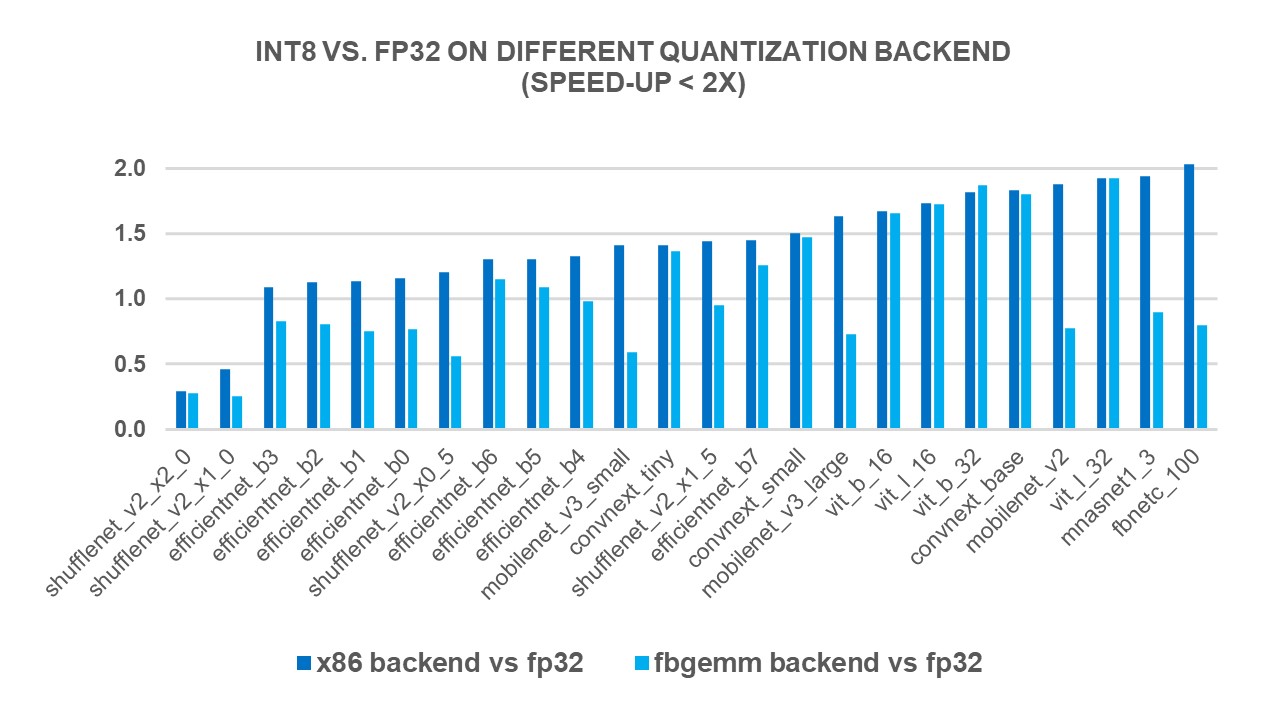

INT8量子化PyTorch x86处理器

2023-08-31 14:27

本白皮书旨在探索实现在赛灵思 DSP48E2 Slice 上的 INT8 深度学习运算,以及与其他 FPGA 的对比情况。在相同资源数量情况下,赛灵思的 DSP 架构凭借 INT8在 INT8 深度

2017-11-16 14:23

赛灵思 INT8 优化为使用深度学习推断和传统计算机视觉功能的嵌入式视觉应用提供最优异的性能和能效最出色的计算方法。与其他 FPGA/DSP 架构相比,赛灵思的集成 DSP 架构在 INT8 深度学习运算上能实现 1.75 倍的性能优势。

2017-09-22 17:27

Intel近日发布了最新版的高性能深度学习优化库DNNL 1.2,证实即将推出的全新Xe架构独立GPU的一项新技能,那就是支持Int8整数数据类型。

2020-02-04 15:31

赛灵思的 DSP 架构和库针对 INT8 运算进行了精心优化。本白皮书介绍如何使用赛灵思 16nm 和 20nm All Programmable 器件中的 DSP48E2 Slice,在共享相同内核权重的同时处理两个并行的 INT8 MACC 运算。

2019-07-29 11:19

安装OpenVINO™ 2024.0 版本。 使用 optimum-intel 程序包将 whisper-large-v3 模型转换为 int 4 和 int8,并在 GPU 上使用 OpenVINO™ 运行推理。 没有可用的输出。

2025-06-23 07:11

一、int8的输出和fp32模型输出差异比较大 解决方案: 检查前后处理是否有问题,int8网络输入输出一般需要做scale处理,看看是否遗漏? 通过量化可视化工具分析int8的输出和fp32

2023-09-19 06:09

一 试着将模型进行了esp-dl上int16和int8的量化,并在测试数据集上进行精度评估,其中int16的模型精度基本没有下降,但是int8的模型评估精度下降了很多,

2024-06-28 15:10