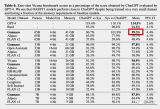

难以达到最佳性能。为了提升模型在特定任务上的表现,微调(Fine-tuning)成为了一个关键步骤。本文将详细探讨大模型为什么要进行微调以及微调的原理,并附上相关的代码示例。

2024-07-10 10:43

除了提高性能之外,还能缩短提示时间,确保类似性能。另外,微调目前仅支持处理4000 tokens,这也是此前微调型号的两倍。16k tokens微调将于今年秋季推出。

2023-08-24 16:39

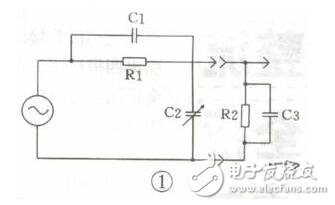

微调电容器是电容器的一种,但是它属于电容却和普通电容有一个区别,就是改变电容量大小。

2019-11-25 09:45

MFTCoder具备高效训练特征,包括提供高效的数据Tokenization模式和支持PEFT微调,能有效提升微调训练速度并降低对资源的需求。

2023-11-17 17:17

一起提出的新方法 QLoRA 把微调大模型的 显存需求从>780GB降低到 。 开源社区直接开始狂欢,相关论文成为24小时内关注度最高的AI论文。 以Meta的美洲驼LLaMA为基础,得到原驼

2023-06-02 15:26

这篇论文试图解决的问题是大型预训练模型在下游任务中进行微调时出现的过拟合问题。尽管低秩适应(LoRA)及其变体通过学习低秩增量矩阵有效地减少了与完全微调方法相比的可训练参数数量。

2024-04-02 16:46

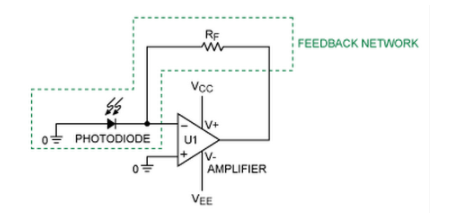

本应用笔记解释了用于评估稳定性的经验计算,然后展示了如何微调反馈相位补偿电容器的选择。

2021-06-11 11:03

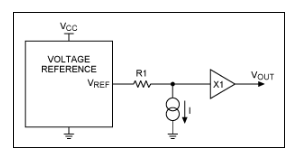

模数转换器(ADC)和数模转换器(DAC)需要稳定的基准电压来精确测量或生成模拟信号。本应用笔记介绍了如何使用电阻、吸电流/源极和缓冲放大器调整任何三端基准电压源,以动态校准基准电压源、微调其输出值或生成略有不同的值。

2023-02-07 14:32

现有的文本嵌入表示方法在应用到新的任务或领域时,通常性能都会受损,甚至应用到相同任务的不同领域也会遇到同样的问题。常见的解决办法是通过针对下游任务和领域的数据集进一步微调文本嵌入,而这个工作通常需要大量的注释数据。

2023-09-05 17:13

16.7。自然语言推理:微调 BERT¶ Colab [火炬]在 Colab 中打开笔记本 Colab [mxnet] Open the notebook in Colab Colab

2023-06-05 15:44