GPT,全称Generative Pretrained Transformer,是OpenAI公司在自然语言处理(NLP)领域的一项重大创新。这一模型不仅推动了AI技术的边界,还深刻影响了我们与机器交互的方式。本文将从GPT

2024-07-10 10:41

人类语言与蛋白质有很多共同点,至少在计算建模方面。这使得研究团队将自然语言处理(NLP)的新方法应用于蛋白质设计。其中,德国Bayreuth大学Birte Höcker的蛋白质设计实验室,描述了基于OpenAI的GPT-2的语言模型ProtGPT2,以基于自然序列

2022-09-08 16:24

在谈GPT 2.0之前,先回顾下它哥GPT 1.0,这个之前我在介绍Bert模型的时候介绍过,过程参考上图,简述如下:GPT 1.0采取预训练+FineTuning两个阶段,它采取

2019-02-18 09:56

根据Patel和Nishball的说法,此前屡屡被爆料将成为GPT-4大杀器的谷歌Gemini,已经开始在新的TPUv5 Pod上进行训练了,算力高达~1e26 FLOPS,比训练GPT-4的算力还要大5倍。如今,凭借着TPUv5,谷歌已经成为了算力王者。

2023-09-04 16:02

面试环节第一步——回答问题,写软件需求 面试环节第二步——上手写代码 测试用例 比 ChatGPT 背后 GPT-3.5 更为强大的模型 GPT-4,已正式对外发布。在 OpenAI 官方

2023-06-16 10:42

虽然GPT-3没有开源,却已经有人在复刻GPT系列的模型了。 例如,慕尼黑工业大学的Connor Leahy,此前用200个小时、6000RMB,复现了GPT-2。 又例如,基于150亿参数

2021-02-13 09:24

GPT是一种基于Transformer的预训练语言模型,可以用于自然语言处理中的各种任务。在态势感知中,GPT可以用来对文本进行分类和情感分析,从而帮助用户了解当前的舆情和社会热点。例如,在某个

2023-07-07 11:23

该研究提出了一个简单而有效的框架 Control-GPT,它利用 LLM 的强大功能根据文本 prompt 生成草图。Control-GPT 的工作原理是首先使用 GPT-4 生成 TikZ 代码形式的草图。如下图

2023-06-05 15:31

能有这样出色的表现,不是没有原因的,GPT-2各种特定领域的语言建模任务中都取得了很好的分数。作为一个没有经过任何领域数据专门训练的模型,它的表现,比那些专为特定领域数据集(例如维基百科,新闻,书籍)上训练的模型。有图有真相:

2019-03-07 14:45

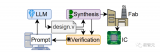

GPT-4已经会自己设计芯片了!芯片设计行业的一个老大难问题HDL,已经被GPT-4顺利解决。并且,它设计的130nm芯片,已经成功流片。 GPT-4,已经可以帮人类造芯片了! 只用简单的英语

2023-06-20 11:51