专门针对序列到序列的自然语言生成任务,微软亚洲研究院提出了新的预训练方法:屏蔽序列到序列预训练(MASS: Masked Sequence to Sequence Pre-training)。MASS对句子随机屏蔽一个长度为k的连续片段,然后通过编码器-注意力-解

2019-05-11 09:34

来自:圆圆的算法笔记 今天给大家介绍3篇EMNLP 2022中语言模型训练方法优化的工作,这3篇工作分别是: 针对检索优化语言模型 :优化语言模型训练过程,使能够生成更合适的句子表示用于检索

2022-12-22 16:14

程健研究员团队最近提出了一种基于哈希的二值网络训练方法,揭示了保持内积哈希和二值权重网络之间的紧密关系。

2018-02-08 15:38

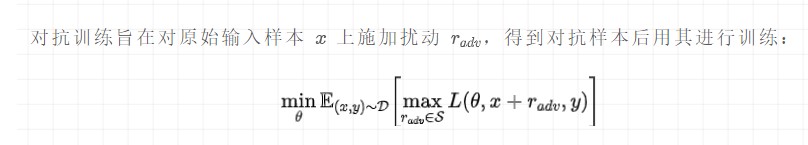

对抗训练本质是为了提高模型的鲁棒性,一般情况下在传统训练的基础上,添加了对抗训练是可以进一步提升效果的,在比赛打榜、调参时是非常重要的一个trick。

2022-11-09 10:17

在算法层面实现对训练过程加速的方法

2019-07-18 09:25

近年来,基于大数据预训练的多模态基础模型 (Foundation Model) 在自然语言理解和视觉感知方面展现出了前所未有的进展,在各领域中受到了广泛关注。在医疗领域中,由于其任务

2023-07-07 11:10

梯度下降是一种非常通用的优化算法,它能够很好地解决一系列问题。梯度下降的整体思路是通过的迭代来逐渐调整参数使得损失函数达到最小值。

2019-04-05 17:09

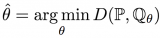

一方面,如果判别网络能力太差,胡乱分辨真假,甚至把真的误认为假的,假的误认为真的,那生成网络就会很不稳定,会努力学习让生成的样本更假——因为弱智的判别网络会把某些假样本当成真样本,却把另一些真样本当成假样本。

2018-05-15 18:22

在 GPT-4 的发布报道上,GPT-4 的多模态能力让人印象深刻,它可以理解图片内容给出图片描述,甚至能在图片内容的基础上理解其中的隐喻或推断下一时刻的发展。

2023-05-22 15:21

掌握这 17 种方法,用最省力的方式,加速你的 Pytorch 深度学习训练。

2024-10-28 14:05