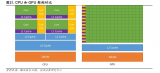

Tensor Core所运行的张量应位于存储器的channel-interleaved型数据布局(数量-高度-宽度-通道数,通常称为NHWC),以实现最佳性能。训练框架预期的内存布局是通道主序的数据布局(数量-通道数-宽度-高度,通常称为NCHW)。因此,cuDNN库执行NCHW和NHWC之间的张量转置操作,如图3所示。如前所述,由于如今卷积本身如此之快,因此这些转置显然会占运行时间的一部分。

2018-05-21 17:35

不同于传统的CPU和GPU架构,Groq从头设计了一个张量流处理器 (TSP) 架构, 以加速人工智能、机器学习和高性能计算中的复杂工作负载。

2022-10-10 11:00

GPU 架构升级过程计算能力不断强化,Hopper 架构适用于高性能计算(HPC)和 AI 工作负载。英伟达在架构设计上,不断加强

2023-05-15 11:16

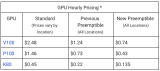

谷歌表示,抢占式GPU(Preemptible GPUs)非常适合短期、容错和批处理工作负载,比如机器学习(ML)和高性能计算(HPC)的客户。使用抢占式GPU,你可以访问大规模GPU基础

2018-06-20 17:41

满足以上两点,就可以用GPU做运算了。 不过你还得先用Open CL 把能在GPU上运行的程序写出来, 这也是很麻烦的,写一下就知道了。 而且GPU的架构比较特殊,要想

2018-05-04 10:06

众所周知,在大型模型训练中,通常采用每台服务器配备多个GPU的集群架构。在上一篇文章《高性能GPU服务器AI网络架构(上篇)》中,我们对

2024-11-05 16:20

新的GPU架构还对整个引擎进行了其他改进,它可以以更高的速率执行可变速率着色,通过额外的工作寄存器执行更快的工作调度,并支持图形的更多固定功能吞吐量。

2023-06-20 10:34

相比于牙膏式升级的Intel第十代酷睿H系列,AMD面向笔记本的锐龙4000系列可谓改天换地,全新的7nm工艺、Zen2 CPU架构以及改进的Vega GPU架构,不但带来了性能上的突飞猛进,续航方面也一改以往尴尬的

2020-04-06 10:25