预训练 AI 模型是为了完成特定任务而在大型数据集上训练的深度学习模型。这些模型既可以直接使用,也可以根据不同行业的应用需求进行自定义。

2023-05-25 17:10

专门针对序列到序列的自然语言生成任务,微软亚洲研究院提出了新的预训练方法:屏蔽序列到序列预训练(MASS: Masked Sequence to Sequence Pre-training)。MASS对句子随机屏蔽一个长度为k的连续片段,然后通过编码器-注意力-解

2019-05-11 09:34

能力,逐渐成为NLP领域的研究热点。大语言模型的预训练是这一技术发展的关键步骤,它通过在海量无标签数据上进行训练,使模型学习到语言的通用知识,为后续的任务微调奠定基础。本文将深入探讨大语言模型预训练的基本原理、步骤以

2024-07-11 10:11

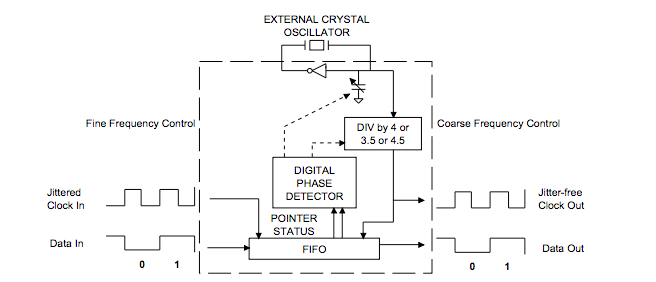

本应用笔记介绍了CS61575和CS61574A的抖动衰减性能。它介绍了抖动衰减器电路的描述以及衰减器设计的性能含义。 抖动衰减器电路说明 本节介绍CS61575和CS

2021-04-14 14:29

CS57302/CS57303是一款高压高速功率半桥驱动电路,主要应用于驱动 N 型 MOS或 IGBT 功率器件的应用系统。

2025-04-23 17:05

神经网络是人工智能领域的重要分支,广泛应用于图像识别、自然语言处理、语音识别等多个领域。然而,要使神经网络在实际应用中取得良好效果,必须进行有效的训练和优化。本文将从神经网络的训练过程、常用优化算法、超参数调整以及防止过拟合等方面,详细阐述如何

2024-07-01 14:14

预训练模型(Pre-trained Model)是深度学习和机器学习领域中的一个重要概念,尤其是在自然语言处理(NLP)和计算机视觉(CV)等领域中得到了广泛应用。预训练模型指的是在大型数据集上预先

2024-07-03 18:20

掌握这 17 种方法,用最省力的方式,加速你的 Pytorch 深度学习训练。

2024-10-28 14:05

PyTorch是一个广泛使用的深度学习框架,它以其灵活性、易用性和强大的动态图特性而闻名。在训练深度学习模型时,数据集是不可或缺的组成部分。然而,很多时候,我们可能需要使用自己的数据集而不是现成

2024-07-02 14:09

在这篇文章中,我们将尽可能详细地梳理一个完整的 LLM 训练流程。包括模型预训练(Pretrain)、Tokenizer 训练、指令微调(Instruction Tuning)等环节。 文末

2023-06-29 10:08