10.7. 用于机器翻译的编码器-解码器 Seq2Seq¶ Colab

2023-06-05 15:44

在 SageMaker Studio Lab 中打开笔记本 在一般的 seq2seq 问题中,如机器翻译(第 10.5 节),输入和输出的长度不同且未对齐。处理这类数据的标准方法是设计一个编码器

2023-06-05 15:44

Encoder-Decoder 是 NLP 领域里的一种模型框架。它被广泛用于机器翻译、语音识别等任务。本文将详细介绍 Encoder-Decoder、Seq2Seq 以及...

2020-12-10 22:19

景智AI编译。翻译/ 崔跃辉、叶倚青校对/ 叶倚青用于循环神经网络的编码-解码架构,在标准机器翻译基准上取得了最新的

2018-07-09 22:53

Seq2Seq-Vis 另一个很有用的功能是它能找出与某个字词相关的训练集,这也是解决 AI 黑盒问题的一大难点。其实一个机器学习模型除了训练集一无所知,所以要解决机器翻译中的错误最终都要回到训练集中去。

2018-12-03 10:02

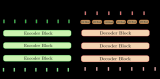

与基于 RNN 的编码器-解码器模型类似,基于 transformer 的编码器-解码器模型由一个编码器和一个

2023-06-11 14:17

本期导读:近年来,序列到序列(seq2seq)方法成为许多文本生成任务的主流思路,在机器翻译、文本摘要等绝大多数生成任务上都得到了广泛的应用。与此同时,一些研究人员另辟蹊径,跳脱出传统

2021-07-23 16:15

基于 transformer 的编码器-解码器模型是 表征学习 和 模型架构 这两个领域多年研究成果的结晶。本文简要介绍了神经编码器-解码器模型的历史,更多背景知识,建

2023-06-16 16:53

基于 transformer 的编码器-解码器模型是 表征学习 和 模型架构 这两个领域多年研究成果的结晶。本文简要介绍了神经编码器-解码器模型的历史,更多背景知识,建

2023-06-20 15:42