预训练(Pre-training)的成本是相当昂贵的(需要4到16个Cloud TPU训练4天),但是对于每种语言来说都只需训练一次(目前的模型仅限英语的,我们打算很快发布多语言模型)。大多数NLP研究人员根本不需要从头开始训练自己的模型。

2018-11-05 17:17

很多读者可能分不清楚 CPU、GPU 和 TPU 之间的区别,因此 Google Cloud 将在这篇博客中简要介绍它们之间的区别,并讨论为什么 TPU 能加速深度学习。

2018-09-06 16:53

TPU材料,即热塑性聚氨酯(Thermoplastic Polyurethane),是一种聚合物材料,具有广泛的应用领域和独特的特点。 TPU材料的主要用途如下: 鞋类行业:TPU材料常用于鞋类

2024-01-16 10:17

带宽模型最大的限制就是这些计算是针对特定矩阵大小的,计算的难度在各种尺寸之间都不同。例如,如果你的batch size是128,那么GPU的速度会比TPU稍快一点。如果batch size小于128

2018-10-21 09:20

TPU(Thermoplastic Polyurethane)是热塑性聚氨酯的简称,属于一种高强度、高弹性、高耐磨的特种塑料材料。它是由聚醚或聚酯两元醇与三元异氰酸酯或四元稀土异氰酸酯通过共聚反应

2024-01-12 13:40

CPU、GPU、TPU、NPU等的讲解

2021-01-05 14:54

云TPU包含8个TPU核,每个核都作为独立的处理单元运作。如果没有用上全部8个核心,那就没有充分利用TPU。为了充分加速训练,相比在单GPU上训练的同样的模型,我们可以选择较大的batch尺寸。总batch尺寸定为1

2018-11-16 09:10

张量处理单元(TPU)是一种定制化的 ASIC 芯片,它由谷歌从头设计,并专门用于机器学习工作负载。TPU 为谷歌的主要产品提供了计算支持,包括翻译、照片、搜索助理和 Gmail 等。

2018-09-04 16:04

张量处理单元(TPU,Tensor Processing Unit)是一种专门为深度学习应用设计的硬件加速器。它的开发源于对人工智能(AI)和机器学习应用的需求,尤其是深度学习中的神经网络计算。

2025-04-22 09:41

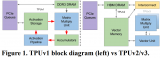

在Google I/O 2016的主题演讲进入尾声时,谷歌的CEO皮采提到了一项他们这段时间在AI和机器学习上取得的成果,一款叫做Tensor Processing Unit(张量处理单元)的处理器,简称TPU。在这个月看来,第一代的TPU处理器已经过时。

2017-05-19 11:49