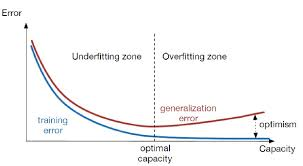

过拟合是指模型在训练集上表现很好,到了验证和测试阶段就大不如意了,即模型的泛化能力很差。

2020-01-29 17:48

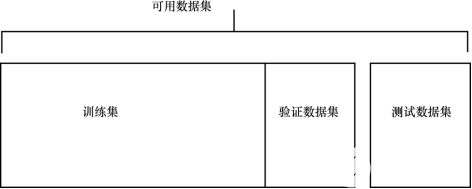

本章涵盖了以下主题: · 分类和回归之外的其他类型的问题; · 评估问题,理解过拟合、欠拟合,以及解决这些问题的技巧; · 为深度学习准备数据。 请记住,在本章中讨论的

2022-07-12 09:28

由于添加了这个正则化项,各权值被减小了,换句话说,就是神经网络的复杂度降低了,结合“网络有多复杂,过拟合就有多容易”的思想,从理论上来说,这样做等于直接防止过拟合(奥卡

2018-04-27 15:23

为了训练出高效可用的深层神经网络模型,在训练时必须要避免过拟合的现象。过拟合现象的优化方法通常有三种。

2020-12-02 14:17

在数据科学学科中, 过度拟合(overfit)模型被解释为一个从训练集(training set)中得到了高方差(variance)和低偏差(bias),导致其在测试数据中得到低泛化(generalization)的模型。

2018-02-07 17:00

测试数据或新数据上表现不佳的现象。为了解决这个问题,正则化(Regularization)技术应运而生,成为深度学习中不可或缺的一部分。本文将从过拟合的原因、表现、正则化的原理、方法及其在深度学习中的应用等方面展开详

2024-07-09 15:56

像识别、自然语言处理和时间序列预测等。然而,神经网络的拟合误差是一个关键问题,影响模型的性能和泛化能力。本文将从多个角度分析神经网络拟合误差的原因、影响因素和解决方案。

2024-07-03 10:36

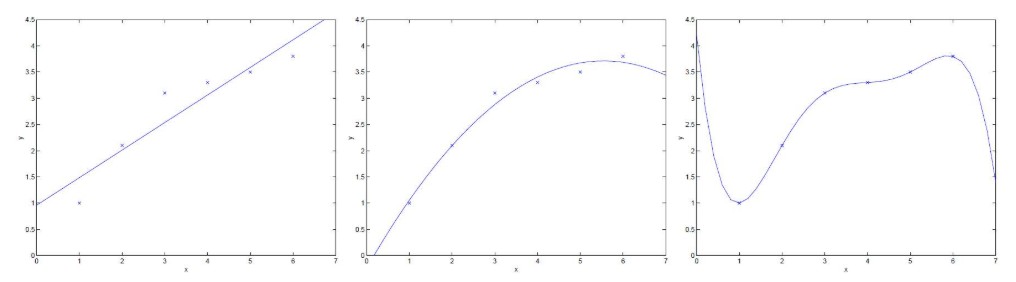

给出多个点,然后根据这些点拟合出一条直线,这个最常见的算法是多约束方程的最小二乘拟合,如下图所示:

2022-08-26 10:36

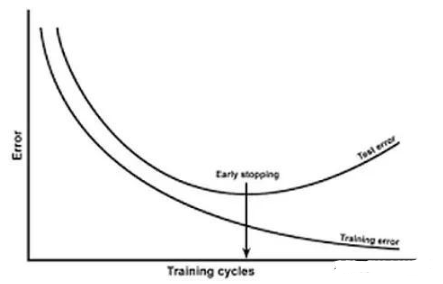

如何判断过拟合呢?我们在训练过程中会定义训练误差,验证集误差,测试集误差(泛化误差)。训练误差总是减少的,而泛化误差一开始会减少,但到一定程序后不减反而增加,这时候便出现了过拟合的现象。

2022-02-12 15:49

丢弃法是一种避免神经网络过拟合的正则化技术。像L1和L2这样的正则化技术通过修改代价函数来减少过拟合。而丢弃法修改神经网络本身。

2020-02-04 11:30