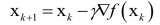

现在我们来讨论梯度下降算法的三个变种,它们之间的主要区别在于每个学习步骤中计算梯度时使用的数据量,是对每个参数更新(学习步骤)时的梯度准确性与时间复杂度的折衷考虑。

2018-05-03 15:55

随机梯度下降(Stochastic gradient descent) 批量梯度下降(Batch gradient descent) 梯度下降(GD)是最小化风险函数、损失函数的一种常用方法,随机

2017-11-28 04:00

这提出了一个问题,生成合成梯度的网络如何学习?当我们进行完整的前向传播和反向传播时,我们实际得到了“正确”的梯度。我们可以将其与“合成”梯度进行比较,就像我们通常比较神经网络输出和数据集一样。因此

2018-05-14 17:32

Minisens在一个混合信号ASIC中集成了霍尔效应传感器和一个磁选机(magnetic concentrator),无需附加的磁芯就可以作直接的电流测量。由于采用无接触式测量,电流不需要流过器件,因此可测的电流水平几乎不受限制。唯一的限制因素是初级导体的热容量。

2019-04-09 13:49

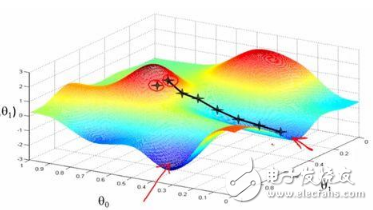

梯度下降法沿着梯度的反方向进行搜索,利用了函数的一阶导数信息。

2023-05-18 09:20

最近在做一个文本检测的项目,在训练的过程中遇到了很严重的梯度爆炸情况,今天就来谈谈梯度爆炸怎么解决。

2018-04-30 19:15

梯度下降法是一个用于寻找最小化成本函数的参数值的最优化算法。当我们无法通过分析计算(比如线性代数运算)求得函数的最优解时,我们可以利用梯度下降法来求解该问题。

2018-04-26 16:44

导读一图胜千言,什么?还是动画,那就更棒啦!本文用了大量的资源来解释各种梯度下降法(gradient descents),想给大家直观地介绍一下这些方法是如何工作的。

2022-08-17 11:50

摘要:反向传播指的是计算神经网络参数梯度的方法。

2023-03-14 11:07

梯度下降法实现简单,当目标函数是凸函数时,梯度下降法的解是全局解。一般情况下,其解不保证是全局最优解,梯度下降法的速度也未必是最快的。

2018-08-04 11:40