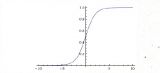

在神经网络中,激活函数是一个至关重要的组成部分,它决定了神经元对于输入信号的反应方式,为神经网络引入了非线性因素,使得

2024-07-01 11:52

和激活函数的非线性变换,能够学习和模拟复杂的函数映射,从而解决各种监督学习任务。本文将详细阐述前馈神经网络的基本结构,包括其组成层、权重和偏置、

2024-07-09 10:31

本文介绍了26个激活函数的图示及其一阶导数,在神经网络中,激活函数决定来自给定输入集的节点的输出,其中非线性

2018-01-11 17:42

希望你理解了激活函数背后的思想,为什么要使用激活函数,以及如何选用激活函数

2018-01-10 11:53

在如今的网络时代,错综复杂的大数据和网络环境,让传统信息处理理论、人工智能与人工神经网络都面临巨大的挑战。近些年,深度学习逐渐走进人们的视线,通过深度学习解决若干问题的案例越来越多。一些传统的图像

2024-01-11 10:51

非线性:当激活函数是线性的时候,一个两层的神经网络就可以基本逼近所有的函数,但是,如果激活

2018-08-02 14:52

BP神经网络和人工神经网络(Artificial Neural Networks,简称ANNs)之间的关系与区别,是神经网络领域中一个基础且重要的话题。本文将从定义、结构、算法、应用及未来发展等多个方面,详细阐述BP

2024-07-10 15:20

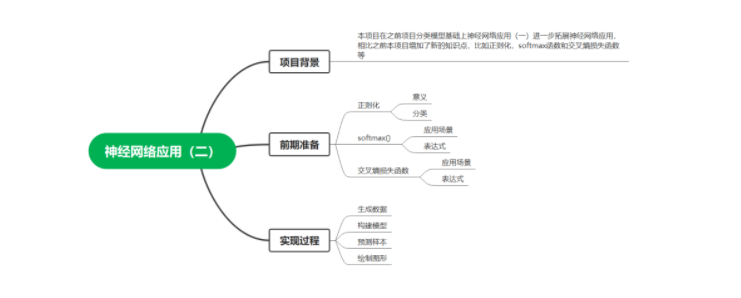

本项目在之前项目分类模型基础上神经网络应用(一)进一步拓展神经网络应用,相比之前本项目增加了新的知识点,比如正则化,softmax函数和交叉熵损失函数等。

2023-02-24 15:43

神经网络从感知机发展到多层前馈神经网络,网络变得越来越复杂。如上一篇 机器学习中的函数(2)- 多层前馈网络巧解“异或”

2022-11-01 11:54

ReLU(Rectified Linear Unit,修正线性单元)训练速度比tanh快6倍。当输入值小于零时,输出值为零。当输入值大于等于零时,输出值等于输入值。当输入值为正数时,导数为1,因此不会出现sigmoid函数反向传播时的挤压效应。

2018-05-16 11:18