模型压缩涉及将大型资源密集型模型转化为适合在受限移动设备上存储的紧凑版本。此外,它还可以优化模型以实现更快的执行速度和最小的延迟,或在这些目标之间取得平衡。

2023-09-26 17:12

基于Transformer架构的大型模型在人工智能领域中发挥着日益重要的作用,特别是在自然语言处理(NLP)和计算机视觉(CV)领域。

2024-02-22 16:27

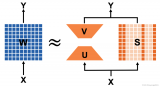

剪枝在高稀疏率时往往不可避免地删除表达神经元,这将导致模型性能严重降低。低秩近似则旨在压缩表达神经元,它对于压缩神经元中的相干部分十分有效,其本质就是提取神经元共享相干子空间的公共基,该方法在 Transformer

2023-07-17 10:50

超参数优化(hyper-parameter optimization)组件:多数开发者对模型压缩算法往往不甚了解,但超参数取值对最终结果往往有着巨大的影响,因此团队引入了超参数优化组件,采用了包括

2018-10-04 09:47

Attention Transfer , 传递teacher网络的attention信息给student网络。首先,CNN的attention一般分为两种,spatial-attention,channel-attention。本文利用的是spatial-attention.所谓spatial-attention即一种热力图,用来解码出输入图像空间区域对输出贡献大小。

2019-07-27 07:08

“Cloud AutoML 产品设计让机器学习的过程变得更简单,让即便没有机器学习经验的人也可以享受机器学习带来的益处。尽管AutoML有很大的进步,这仍是一项相对初期的技术,还有很多方面需要提高和创新。”李佳说。

2018-09-24 08:44

目前很多网络轻量化的工作[1,2,3]利用结构稀疏正则化(下文简称为结构正则化)来对神经网络进行通道剪枝。如公式1所示,这类方法通过在训练过程中加入结构正则化来对网络权重进行结构化约束,使得训练过程中神经网络不同通道的重要性分离开来。在剪枝过程中,网络中重要的通道得以继续保存,而更多冗余的通道可以在不损失网络精度的情况下被安全的移除。

2019-07-07 08:16

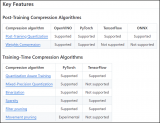

OpenVINO2023版本衍生出了一个新支持工具包NNCF(Neural Network Compression Framework – 神经网络压缩框架),通过对OpenVINO IR格式模型的压缩与量化更好的提

2023-11-20 10:46

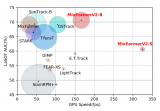

我们通过简洁有效的模型结构设计和高效的基于知识蒸馏的模型压缩,对于现有的 MixFormer 模型进行了大幅度的轻量化提出了 MixFormerV2,同时依旧保持了稳定

2023-11-14 16:54

有损压缩和无损压缩 都是属于压缩技术,但不管是采用何种技术模型,两者的本质内容都是一样的,即都是通过某种特殊的编码方式将数据信息中存在的重复度、冗余度有效地降低,从而达

2017-10-18 09:22