预训练 AI 模型是为了完成特定任务而在大型数据集上训练的深度学习模型。这些模型

2023-05-25 17:10

能力,逐渐成为NLP领域的研究热点。大语言模型的预训练是这一技术发展的关键步骤,它通过在海量无标签数据上进行训练,使模型学习到语言的通用知识,为后续的任务微调奠定基础。

2024-07-11 10:11

在以往的实践中,当我们针对 ultralytics 的 YOLO 模型开展训练工作时,可供选择的计算设备通常局限于 CPU、mps 以及 cuda 这几种。然而,自 PyTorch2.5 版本发布

2024-12-09 16:14

预训练模型(Pre-trained Model)是深度学习和机器学习领域中的一个重要概念,尤其是在自然语言处理(NLP)和计算机视觉(CV)等领域中得到了广泛应用。预训练模型

2024-07-03 18:20

深度学习模型训练是一个复杂且关键的过程,它涉及大量的数据、计算资源和精心设计的算法。训练一个深度学习模型,本质上是通过优化算法调整

2024-07-01 16:13

在《英特尔锐炫 显卡+ oneAPI 和 OpenVINO 实现英特尔 视频 AI 计算盒训推一体-上篇》一文中,我们详细介绍基于英特尔 独立显卡搭建 YOLOv7 模型的训练环境,并完成了 YOLOv7

2023-08-25 11:08

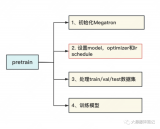

前文说过,用Megatron做分布式训练的开源大模型有很多,我们选用的是THUDM开源的CodeGeeX(代码生成式大模型,类比于openAI Codex)。选用它的原因是“完全开源”与“清晰的

2023-06-07 15:08

NLP中,预训练大模型Finetune是一种非常常见的解决问题的范式。利用在海量文本上预训练得到的Bert、GPT等模型,在下游不同任务上分别进行finetune,得到

2022-03-21 15:33

都知道,AIGC大模型的入局门槛是很高的。玩AI的三大必备要素——算力、算法和数据,每一个都意味着巨大的投入。 以算力为例。ChatGPT的技术底座,是基于微调后的GPT3.5大模型,参数量多达1750亿个。为了

2023-06-27 11:28

让机器做出与人类相似的反应一直是 AI 研究不懈追求的目标。为了让机器具有感知和思考的能力,研究人员进行了一系列相关研究,如人脸识别、阅读理解和人机对话,通过这些任务训练和评估机器在特定方面的智能

2022-04-02 17:26