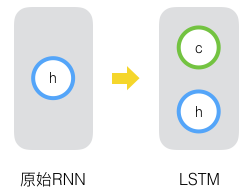

循环神经网络很难训练的原因导致它的实际应用中很处理长距离的依赖。本文将介绍改进后的循环神经网络:长短时记忆网络(Long Short Term Memory Network, LSTM),

2022-02-14 14:40

通过上一篇文章[人工智能之循环神经网络(RNN)] 介绍,我们知道,RNN是一类功能强大的人工神经网络算法,RNN一个重要的优点在于,其能够在输入和输出序列之间的映射过程中利用上下文相关信息。但是RNN存在着梯度消失或梯度爆炸等问题。因此,为了解决上述问题,长短时记忆神经网络(LSTM)诞生了。

2018-06-29 14:44

注意力机制越发频繁的出现在文献中,因此对注意力机制的学习、掌握与应用显得十分重要。本文便对注意力机制做了较为全面的综述。

2019-02-17 09:18

基于心电反馈的注意力缺陷多动障碍矫正仪设计 0 引言 注意力缺陷多动障碍(Attention Deficit Hy-peractivity Disorder,

2009-12-10 10:17

基于心电反馈的注意力缺陷多动障碍矫正仪设计 0 引言 注意力缺陷多动障碍(Attention Deficit Hy-peractivity Disorder,

2009-12-09 10:12

11.5。多头注意力¶ Colab [火炬]在 Colab 中打开笔记本 Colab [mxnet] Open the notebook in Colab Colab [jax

2023-06-05 15:44

SE注意力模块的全称是Squeeze-and-Excitation block、其中Squeeze实现全局信息嵌入、Excitation实现自适应权重矫正,合起来就是SE注意力模块。

2023-05-18 10:23

简而言之,深度学习中的注意力机制可以被广义地定义为一个描述重要性的权重向量:通过这个权重向量为了预测或者推断一个元素,比如图像中的某个像素或句子中的某个单词,我们使用注意力向量定量地估计出目标元素与其他元素之间具有多么强烈的相关性,并由

2019-03-12 09:49

现代互联网经过优化,以尽可能分散注意力。社交网络和其他网站是由曾经居住过的最聪明的软件工程师构建的,通常目标是占用您尽可能多的时间。

2020-03-01 20:44

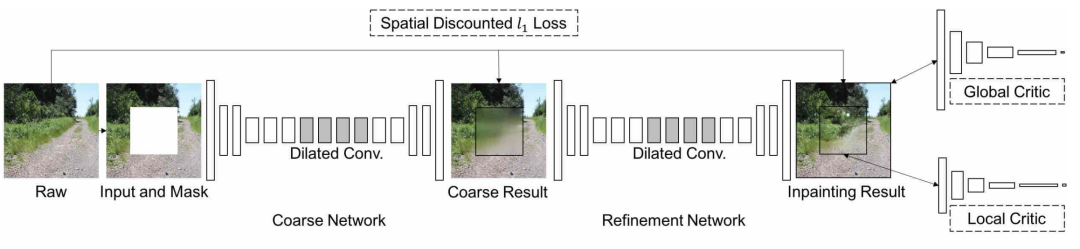

今天,我们将深入探讨深度图像修复的一个突破,上下文注意力。通过使用上下文注意力,我们可以有效地从遥远的空间位置借用信息来重建局部缺失的像素。这个想法实际上或多或少和上一篇的复制-粘贴是一样的。

2021-04-07 19:01