这两个问题都很棘手,显然,为期一天的研讨会肯定讨论不出什么结果。但是在会议现场,一些有远见卓识的NLP研究人员还是探讨了不少方法和想法,其中有一些尤其值得关注。在下文中,我们会介绍它们中的三个主题:巧妙地使用更多归纳偏置;努力构建有“常识”的NLP

2018-08-27 09:47

谷歌推出BERT模型被认为是NLP新时代的开始,NLP终于找到了一种方法,可以像计算机视觉那样进行迁移学习。本文用图解的方式,生动易懂地讲解了BERT和ELMo等模型。

2019-01-03 10:21

在自然语言处理(NLP)领域,循环神经网络(RNN)与卷积神经网络(CNN)是两种极为重要且广泛应用的网络结构。它们各自具有独特的优势,适用于处理不同类型的NLP任务。本文旨在深入探讨RNN与CNN

2024-07-03 15:59

NLP中,预训练大模型Finetune是一种非常常见的解决问题的范式。利用在海量文本上预训练得到的Bert、GPT等模型,在下游不同任务上分别进行finetune,得到下游任务的

2022-03-21 15:33

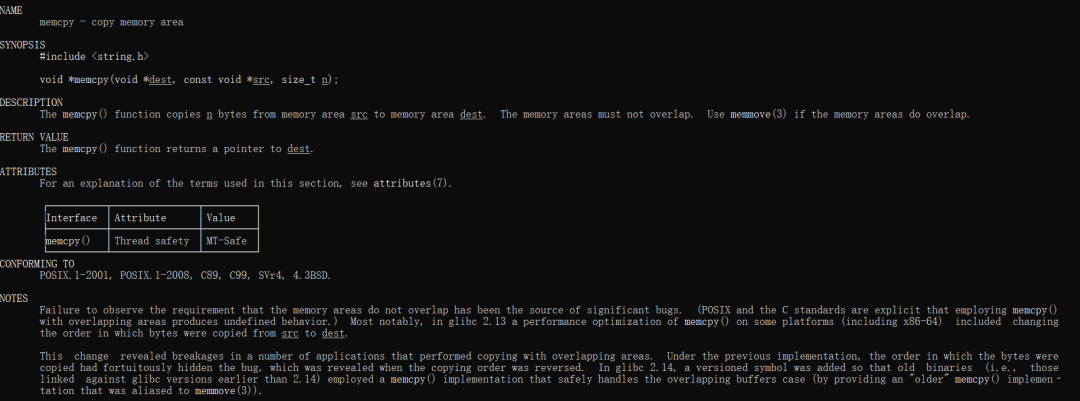

`和 `memmove`的区别是什么呢?这里,在 Linux 里通过 `man`命令查看两个函数的区别,查询的结果如下所示,首先是 `memcpy`函数的阐述。

2023-01-20 16:55

本文用简洁易懂的语言,讲述了自然语言处理(NLP)的前世今生。从什么是NLP到为什么要学习NLP,再到如何利用机器学习进行NLP,值得一读。这是该系列的第一部分,介绍了

2018-06-10 10:26

面我们介绍了 Word Embedding,怎么把一个词表示成一个稠密的向量。Embedding几乎是在 NLP 任务使用深度学习的标准步骤。我们可以通过 Word2Vec、GloVe 等从未标注数据无监督的学习到词的 Embedding,然后把它用到不同的特定任务中。

2019-01-20 09:24

LLM(Large Language Model)是指大型语言模型,它们是一类使用深度学习技术构建的自然语言处理(NLP)模型。LLM模型可以处理各种语言任务,如文本生

2024-07-09 09:55

该项目是对基于深度学习的自然语言处理(NLP)的概述,包括用来解决不同 NLP 任务和应用的深度学习模型(如循环神经网络、卷积神经网络和强化学习)的理论介绍和实现细节,以及对

2019-03-01 09:13

方向是自然语言处理的同学们有福啦,为了跟踪自然语言处理(NLP)的进展,有大量仁人志士在 Github 上维护了一个名为 NLP-Progress 的库。它记录了几乎所有NLP任务的 baseline 和 标准数据集

2018-11-17 09:21