简而言之,深度学习中的注意力机制可以被广义地定义为一个描述重要性的权重向量:通过这个权重向量为了预测或者推断一个元素,比如图像中的某个像素或句子中的某个单词,我们使用注意力向量定量地估计出目标元素与其他元素之间具有多么强烈的相关性,并由

2019-03-12 09:49

注意力机制越发频繁的出现在文献中,因此对注意力机制的学习、掌握与应用显得十分重要。本文便对注意力机制做了较为全面的综述。

2019-02-17 09:18

11.5。多头注意力¶ Colab [火炬]在 Colab 中打开笔记本 Colab [mxnet] Open the notebook in Colab Colab [jax

2023-06-05 15:44

SE注意力模块的全称是Squeeze-and-Excitation block、其中Squeeze实现全局信息嵌入、Excitation实现自适应权重矫正,合起来就是SE注意力模块。

2023-05-18 10:23

同时我们还将完整的GAN结构和我们网络的部分相对比:A表示只有自动编码器,没有注意力地图;A+D表示没有注意力自动编码器,也没有注意力判别器;A+AD表示没有注意力自动

2018-08-11 09:22

通过引入像素注意力,PAN在大幅降低参数量的同时取得了非常优秀的性能。相比通道注意力与空域注意力,像素注意力是一种更广义的注意力

2022-10-27 13:55

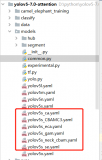

视觉注意力机制的各种模块是个好东西,即插即用,可以添加到主流的对象检测、实例分割等模型的backbone与neck中,实现轻松涨点,本文使用OID数据集的2000多张数据,基于YOLOv5s

2023-06-02 14:52

的基于注意力的方法(使用 MLP),如图 16.5.1所示。 图 16.5.1本节将预训练的 GloVe 提供给基于注意力和 MLP 的架构以进行自然语言推理。¶ 16.5.1。该模型¶ 比保留前

2023-06-05 15:44

本文深入浅出地介绍了近些年的自然语言中的注意力机制包括从起源、变体到评价指标方面。

2019-01-25 16:51

基于以上观察,我们提出了特征金字塔注意力模块 (FPA),该模块能够融合来自 U 型网络 (如特征金字塔网络 FPN) 所提取的三种不同尺度的金字塔特征。为了更好地提取不同尺度下金字塔特征的上下文信息,我们分别在金字塔结构中使用 3×3, 5×5, 7×7 的卷积核。

2018-06-05 09:21