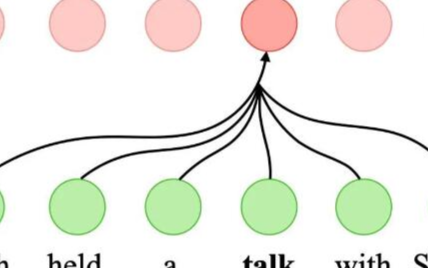

简而言之,深度学习中的注意力机制可以被广义地定义为一个描述重要性的权重向量:通过这个权重向量为了预测或者推断一个元素,比如图像中的某个像素或句子中的某个单词,我们使用注意力向量定量地估计出目标元素与其他元素之间具有多么强烈的相关性,并由

2019-03-12 09:49

序列表征循环神经网络卷积神经网络注意力文本生成变换器编码器自注意力解码器自注意力残差的重要性图像生成概率图像生成结合注意力

2019-07-19 14:40

注意力机制越发频繁的出现在文献中,因此对注意力机制的学习、掌握与应用显得十分重要。本文便对注意力机制做了较为全面的综述。

2019-02-17 09:18

自注意力网络(SANs)在许多自然语言处理任务中取得显著的成功,其中包括机器翻译、自然语言推理以及语义角色标注任务。

2020-08-31 10:45

输入文本的要点; (2)模型过度依赖语言模型,生成流畅但不充分的单词。 在本文研究中,提出了一个忠实增强摘要模型

2022-11-01 11:37

视觉注意力机制的各种模块是个好东西,即插即用,可以添加到主流的对象检测、实例分割等模型的backbone与neck中,实现轻松涨点,本文使用OID数据集的2000多张数据,基于YOLOv5s

2023-06-02 14:52

摘要本文提出一种基于注意力机制的用户异构行为序列的建模框架,并将其应用到推荐场景中。

2018-01-25 17:59

同时我们还将完整的GAN结构和我们网络的部分相对比:A表示只有自动编码器,没有注意力地图;A+D表示没有注意力自动编码器,也没有注意力判别器;A+AD表示没有注意力自动

2018-08-11 09:22

然而,在基于梯度的学习框架(如深度学习)中存在一个关键的缺点:因为选择要处理的信息的过程是离散化的,因此也就是不可微分的,所以梯度不能反向传播到选择机制中来支持基于梯度的优化。目前研究人员正在努力来解决视觉注意力、文本注意力

2018-08-10 08:44

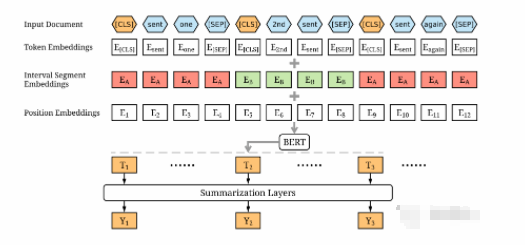

最近在梳理文本摘要相关内容,翻到一篇19年关于基于BERT模型进行抽取式摘要的老文「BertSum」,在这里分享给大家。该论文一开始挂在arXiv时,为《Fine-

2022-03-12 16:41