近日,蚂蚁集团高级技术专家杨洋(花名:凯申 )发文称,国内著名Web服务器和反向代理开源软件Tengine已完成了对BabaSSL的适配工作,并增加了对NTLS相关能力的支持。 ▼ 至此,对我国密码

2022-01-14 12:49

本期讲解便是基于 Tengine 实现 yolov4的 cpu推理。完成动机:主要是为了熟悉tengine的推理部署流程一、模型转换采用下面链接中yolov4的...

2020-12-15 00:19

大佬说选择移植Tengine Python API这个任务,一方面是因为他之前做过涉及Python和C++/C交互的开源项目工作,如 MXNet 中DLPack的Python ...

2020-12-15 00:30

不同的量化策略,得到的结果可能稍有差异,另外高版本上的INT8量化之后到低版本的TensorRT机器上可能无法运行,我就遇到过!所以建议不同平台要统一TensorRT版本之后,再量化部署会比较好。上面的Calibrator都必须完成四个方法,分别是:

2022-09-23 14:47

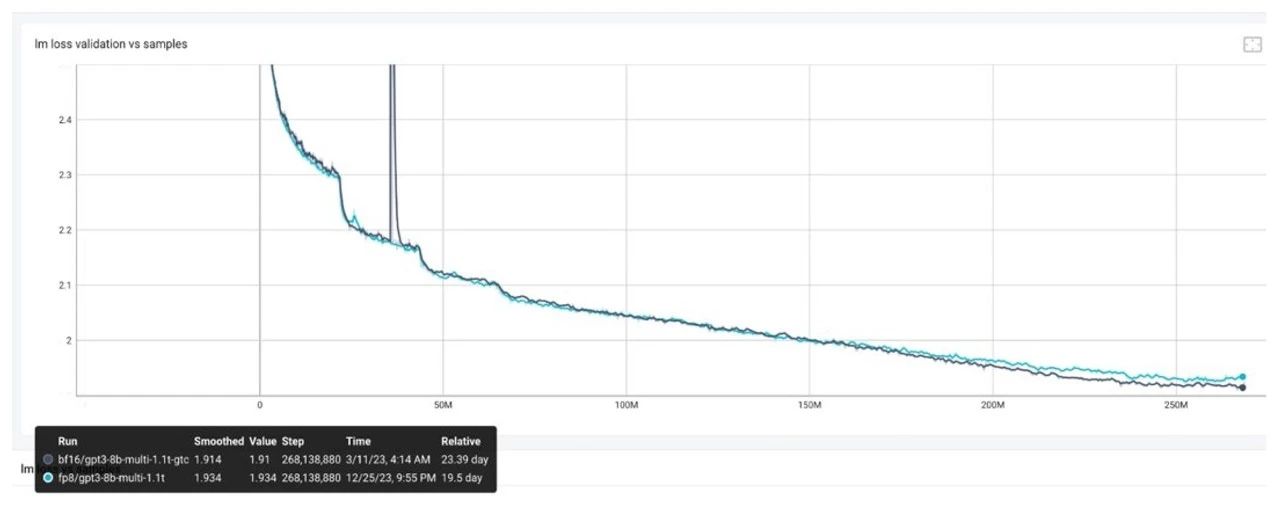

利用 FP8 技术加速 LLM 推理和训练越来越受到关注,本文主要和大家介绍如何使用 FP8 这项新技术加速大模型的训练。 使用 FP8 进行大

2024-12-09 11:30

现在,HCL计算库作为Tengine的插件,是性能最快的Arm CPU NN计算库,并且支持动态8位量化计算,精度几乎不变,相比于NCNN最快能带来2-3倍的性能提升,内存使用减少为三分之一。

2018-09-21 11:26

目前,市场上许多公司都积极开展基于 FP8 的大模型训练,以提高计算效率和性能。在此,我们整理并总结了客户及 NVIDIA 技术团队在 FP8 模型训练过程中的 deb

2024-09-06 14:36

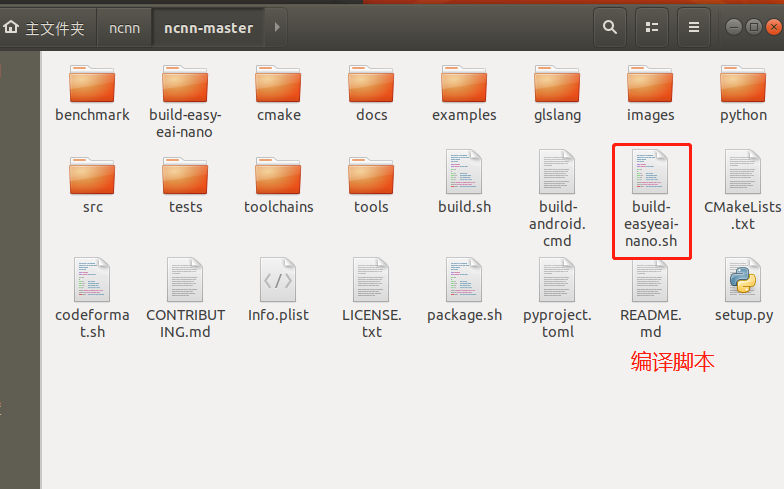

本文是基于EASY EAI Nano移植NCNN部署库的方法与NCNN成功运行yolov4的Demo所做的教程。

2022-07-19 09:02