不同的量化策略,得到的结果可能稍有差异,另外高版本上的INT8量化之后到低版本的TensorRT机器上可能无法运行,我就遇到过!所以建议不同平台要统一TensorRT版本之后,再量化部署会比较好。上面的Calibrator都必须完成四个方法,分别是:

2022-09-23 14:47

现在,HCL计算库作为Tengine的插件,是性能最快的Arm CPU NN计算库,并且支持动态8位量化计算,精度几乎不变,相比于NCNN最快能带来2-3倍的性能提升,内存使用减少为三分之一。

2018-09-21 11:26

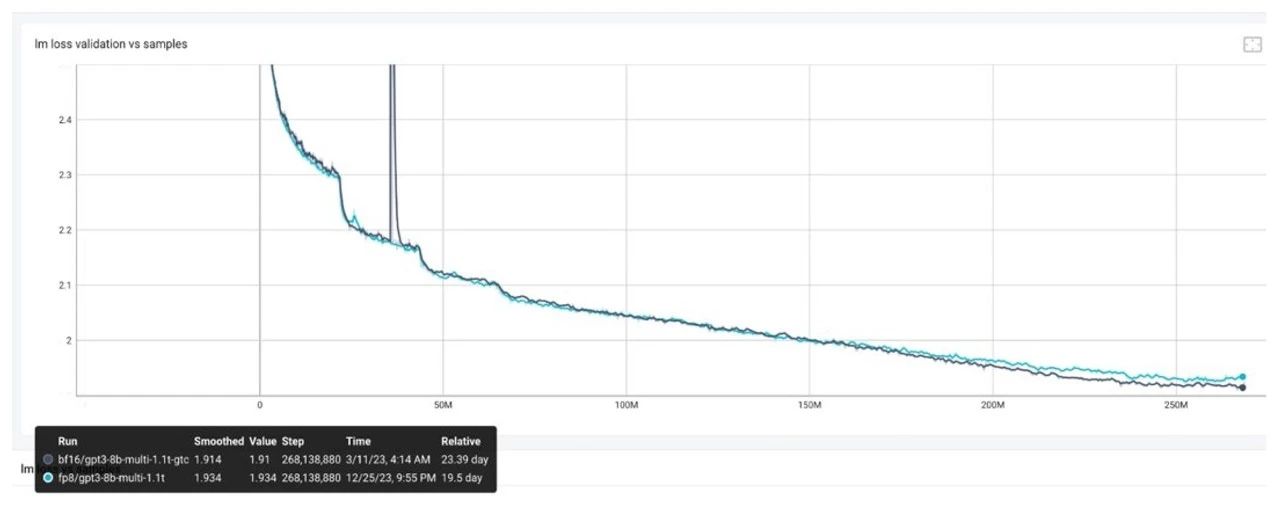

目前,市场上许多公司都积极开展基于 FP8 的大模型训练,以提高计算效率和性能。在此,我们整理并总结了客户及 NVIDIA 技术团队在 FP8 模型训练过程中的 deb

2024-09-06 14:36

穿透工具,找了几个要么不免费,要么各种验证,还是放弃吧。 得益于四核A53的性能,NCNN跑起来应该问题不大,本文主要介绍NCNN在MangoPi MQ Quad上的部署和测试。 一、NCNN介绍

2023-07-22 09:10

本文主要介绍了 FP8 数据格式在大型模型训练中的应用、挑战及最佳实践,展示了 FP8 在提升训练速度和效率方面的潜力和实际效果。

2024-11-19 14:54

今天简报较短,主要演示一下如何在RT-Thread OS环境下使用ncnn进行AI推理

2023-05-04 16:29

量化工具以 ONNX 文件和部分图片为输入,将神经网络从 FP32 量化为 INT8 精度,目前支持 PTQ 与 QAT 功能。仅需在代码中将量化和编译工具导入并通过 API 调用,即可对 ONNX 模型完成量化和编译

2023-09-27 17:14

在初次使用调制驱动器时,有几个注意事项需要考虑。

2023-07-10 11:47

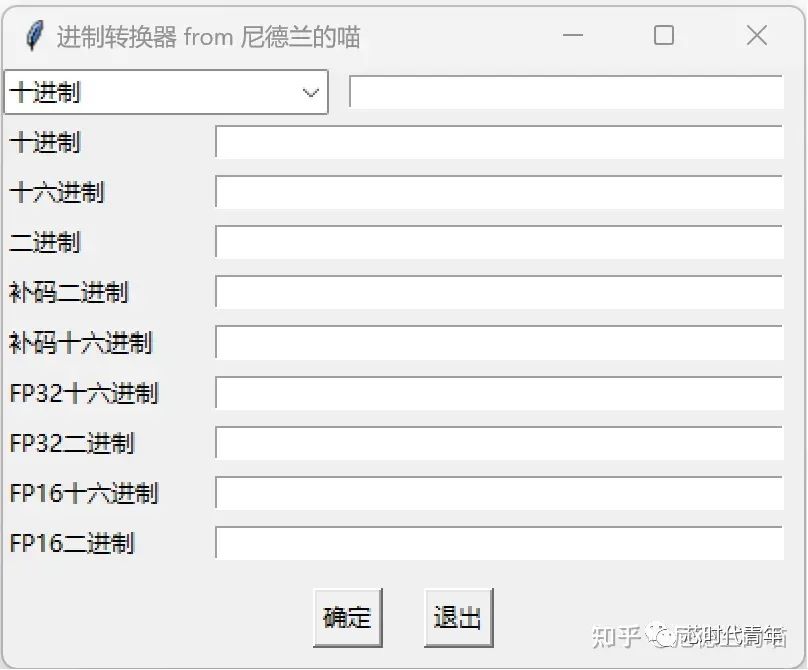

[浮点数]()在计算机科学中是一种重要的数据类型,用于表示实数。其中,FP32和FP16是两种常见的浮点数格式,分别占用32位和16位。

2023-12-04 14:00

本文开始介绍了什么是光纤适配器和光纤适配器的特点,其次分析了光纤适配器性能指标、分类以及常见的几种光纤连接器,最后阐述了光纤适配器的作用与应用范围。

2018-02-26 16:22