对于位置编码,常规的做法是在计算 query, key 和 value 向量之前,会计算一个位置编码向量 pi 加到词嵌入 xi 上,

2023-07-10 10:12

等模型不同,对于Transformer来说,位置编码的加入是必要的,因为单纯的self-attention机制无法捕捉输入的顺序,

2021-04-01 16:07

我们先来回顾一下绝对位置编码的问题。绝对位置编码通过可学习的 Positional Embedding 来编码位置信息,

2024-01-16 11:37

自1989年初代WCS位置编码系统问世至今,倍加福始终致力于产品的完善与优化。此次,WCS系统再度升级,新款系统集成有EtherCAT 接口。采用这一全新的现场总线接口,WCS 读头能将检测到的位置

2022-09-30 14:09

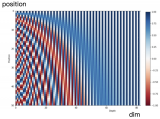

无论是缩放位置索引还是修改基地,所有token都变得彼此更接近,这将损害LLM区分相近token的位置顺序的能力。结合他们对RoPE的波长的观察,存在一些波长比预训练的上下文窗口长的维度,NTK-by-parts插值的作者建议完全不插值较高的频率维度。

2024-01-08 09:58

11.6. 自注意力和位置编码¶ Colab [火炬]在 Colab 中打开笔记本 Colab [mxnet] Open the notebook in Colab Colab [jax

2023-06-05 15:44

这种编码方式又叫做 Sinusoidal编码 。直觉上看,第个位置的表征向量维度是 ,这个向量的奇数位置元素使用余弦值,偶数位置

2023-09-06 10:04

变化。测量所需的能量可通过能量采集解决方案获得或由电池提供。使用霍尔传感器的磁性位置测量,可以集成到包含完整信号调理电路的单芯片编码器中。

2018-02-20 22:33

神经网络知识。 有一种叫做注意机制的东西,但是你不需要知道注意力具体实现。 RNN/LSTM的不足。 A. Vaswani等人的《Attention Is All You Need》被认为是解决了众所周知的LSTM/RNN体系结构在深度学习空间中的局限性的突破之一。本文介绍了transformers 在seq2seq任务中的应用。该论文巧妙地利用了 D.Bahdanau 等人通过联合学习对齐和翻译的神经机器翻译注意机制的使用。并且提供一些示例明确且详尽地解释了注意力机制的数学和应用。 在本文中,我将专注于注意力机

2021-06-16 17:19

历经时间考验的WCS位置编码器系统,以其毫米级的精度,在输送系统等众多领域展现出了超卓的性能。其坚固耐用的设计,更是让它在室外或恶劣环境下也能稳定工作。

2025-03-31 14:05